1_bit(ビット)とbyte(バイト)を簡単に言うと

コンピュータが情報を扱う最小単位(=bit)とそのまとまり(=byte)を示しています。

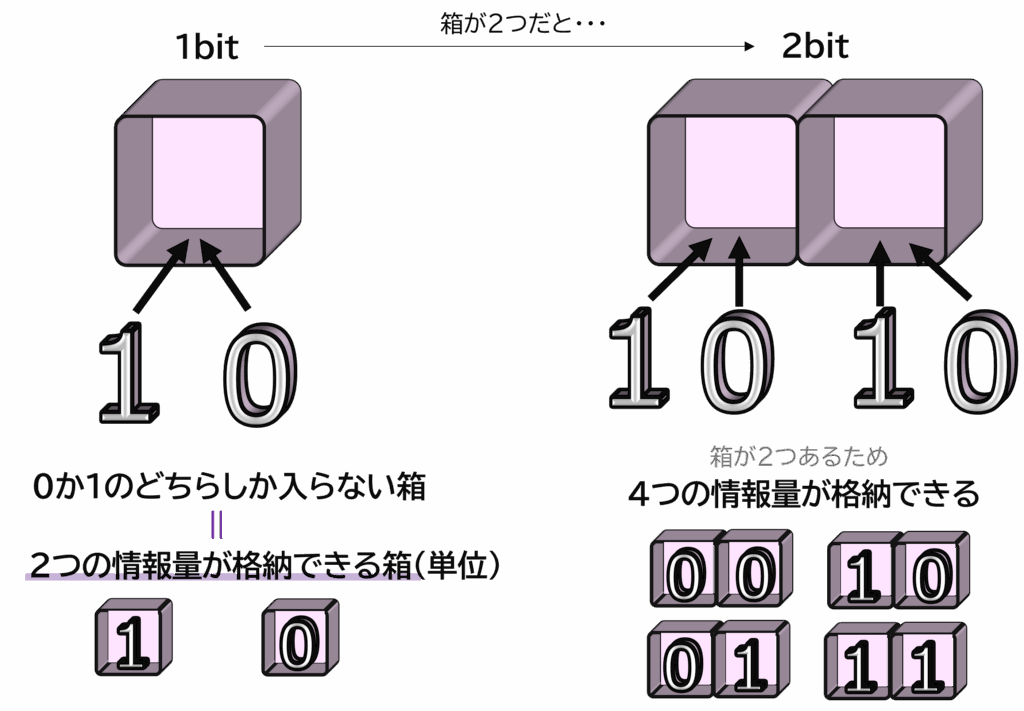

bit(ビット) =binary digit の略で、「0」か「1」の二つの状態だけで情報を表す最小単位を表しています。1bit は情報量として0と1の2パターンを表現でき、2bitは、0と1の2パターンが×2となるため、4つの情報量を格納できると言えます。

※前回の記事で、数値を0と1で表現するニ進数を説明しましたが、考え方はかなり近いです。

ただし、bitが0か1の情報を含んでいる2パターンを表しているのに対して、2真数は、実際のbitが1や0という値を含んで、特定の意味(数値)表している状態を指しているといってもいいと思います。

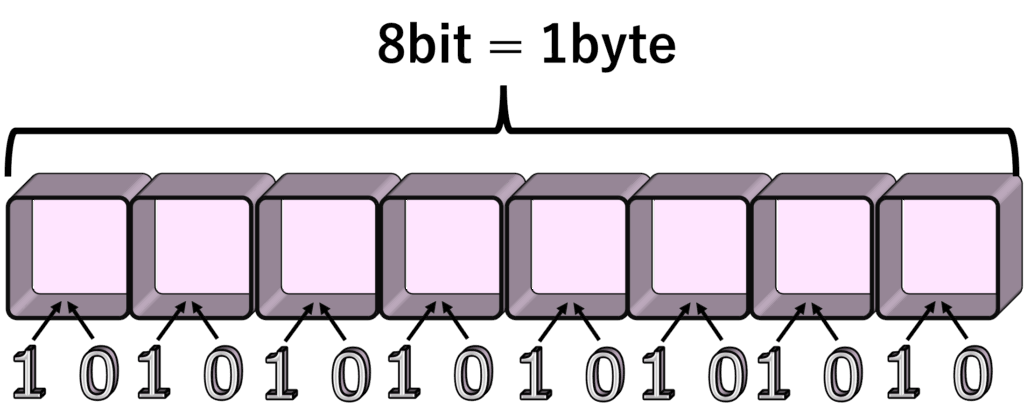

byteとは、8bitの情報量を持つ単位を指します(1byte = 8bit)。データの情報量が大きくなると、bitでは表現しきれなくなるため、まとまりの単位が存在します。よく皆様がファイルで保存する際に見ているのはこちらです。一般的にはKByte(キロバイト)の単位が一般的かと思います。

2_図解化

バグ太郎

なんでこのような考え方が必要なのですか?

C-3PU

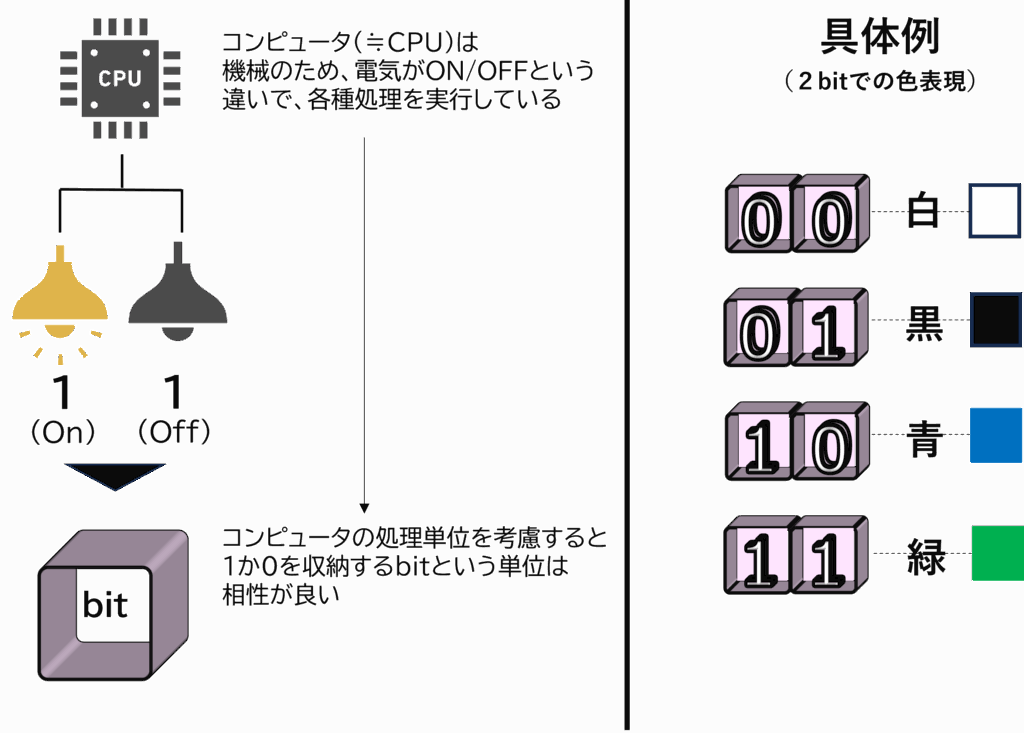

コンピュータ内部では「電気信号がON=1/OFF=0」で各種処理が行われているため、このbitという最小単位が使用されます。

C-3PU

データ量が大きい場合は、基本的に8bitをまとめたbyteという単位が使用されます。このbyteという単位もデータ大きくなるに連れて、K(キロ)・M(メガ)・G(ギガ)と単位が上がっていきます。

コメント